Ollama , une intelligence artificielle (IA) local sur Docker !!

Qu’est ce qu’Ollama ?

Pour commencer, bonjour et bienvenue sur mon blog Technologie Geek ! Voyons ensemble comment déployer une intelligence artificielle local sur Docker ! Ollama est un outil d’IA vous permettant d’exécuter localement de grands modèles de langage llm. Ensuite, vous pouvez créer ainsi que personnaliser des modèles de langages selon vos envies. En installant votre IA Ollama sur Docker, vous vous libérez des plateformes basées sur le cloud. Disponible sur MacOS, linux et bientôt Windows. Vous pourrez également vous connecter aux API tel que ChatGPT (Openai), Mistral AI…

En résumé, l’outil d’intelligence artificielle Ollama est une solution puissante qui rend l’intelligence artificielle accessible à tout le monde. Avec sa capacité à s’intégrer de manière fluide, à apprendre continuellement et à fournir des résultats tangibles, Ollama est à la pointe de la révolution technologique.

Que vous faut-il ?

Pour installer une intelligence artificielle local comme Ollama, il vous faut :

- Premièrement, une installation de Docker.

- Deuxièmement, Portainer sur Docker.

Pour finir, nous allons utiliser le modèle llama3.2. Vous trouverez les modèles disponibles à l’adresse https://ollama.ai/library.

Installation de votre intelligence artificielle local Docker :

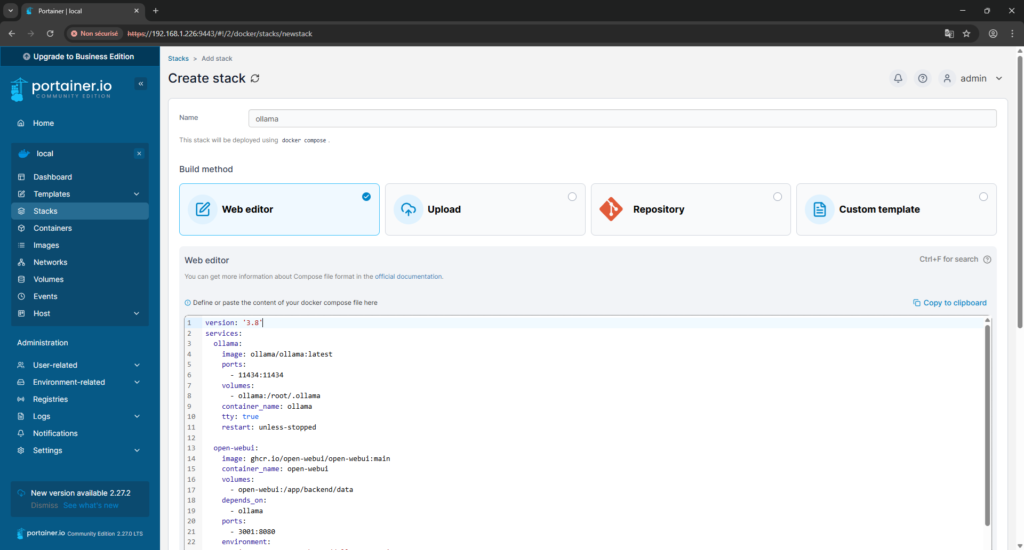

Tout d’abord, aller sur la page d’administration de Portainer, puis sélectionner votre « environnement local ». Ensuite, cliquer sur « Stacks », « add Stack » puis sur « Editor ». Donner lui un nom et enfin copier et coller le code ci-dessous :

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- 11434:11434

volumes:

- ollama:/root/.ollama

container_name: ollama

tty: true

restart: unless-stopped

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

ports:

- 3001:8080

environment:

- 'OLLAMA_BASE_URL=http://ollama:11434'

- 'WEBUI_SECRET_KEY='

extra_hosts:

- host.docker.internal:host-gateway

restart: unless-stopped

volumes:

ollama: {}

open-webui: {}

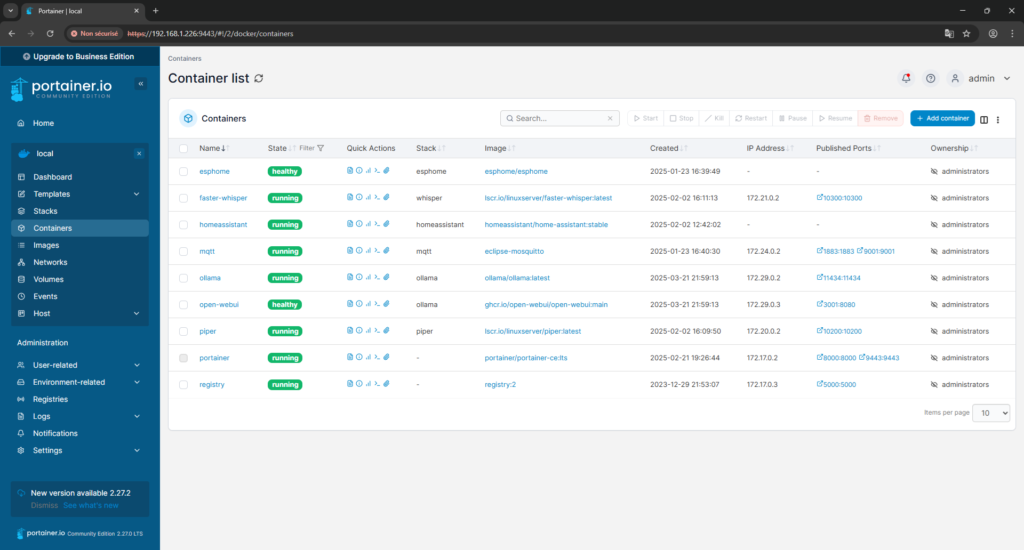

Ensuite, cliquer sur « Deploy the stack » pour installer votre intelligence artificielle local sur Docker. Une fois déployé, vous devez voir deux conteneurs apparaitre.

- Premièrement, un conteneur « ollama ».

- Deuxièmement, un autre nommé « ollama-webui ».

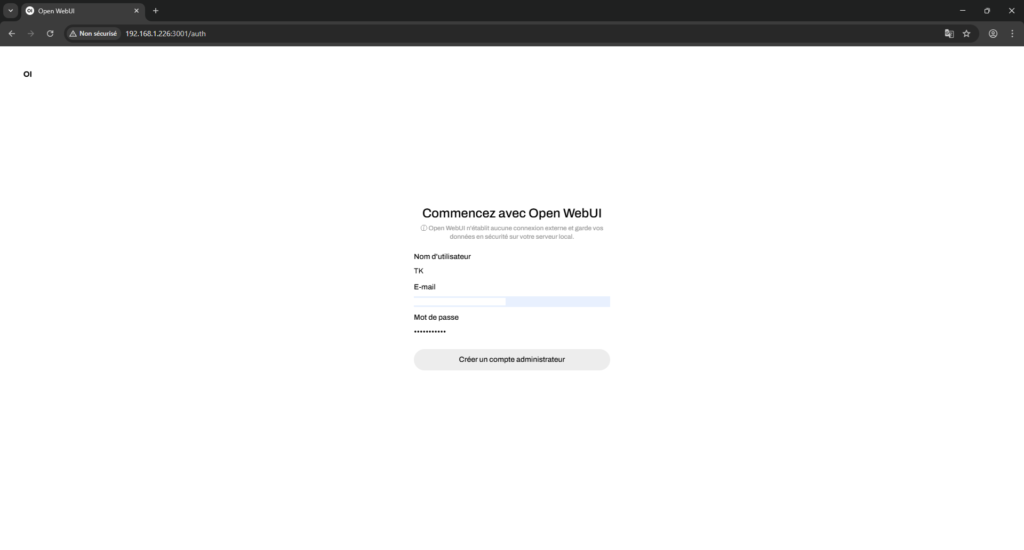

Ça y est, votre IA sur Docker est prête ! Rendez-vous à l’adresse « http://ip-de-votre-serveur:3001 », pour ma part « http://192.168.1.226:3001 ». Ensuite, sur la page d’accueil cliquer sur « Sign up », puis renseigner un identifiant, une adresse mail ainsi qu’un mot de passe.

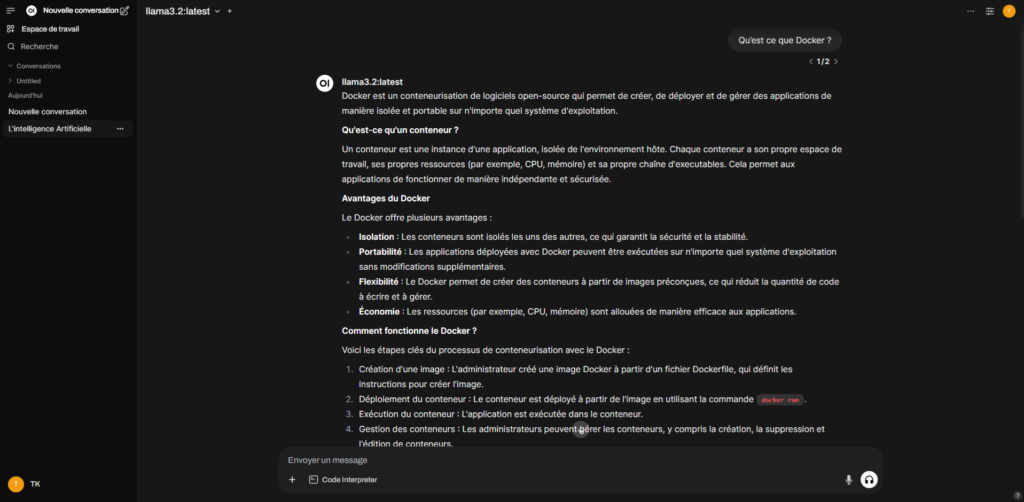

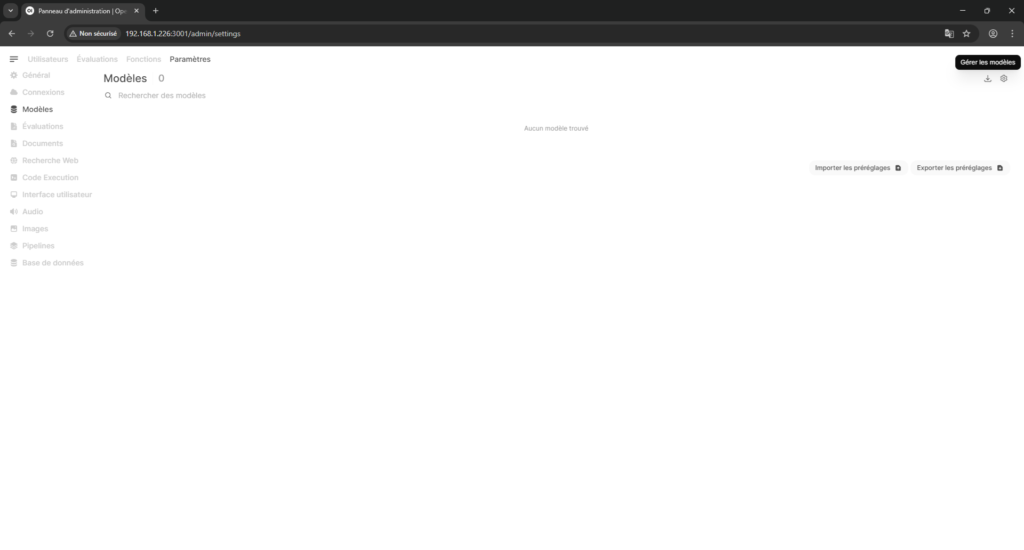

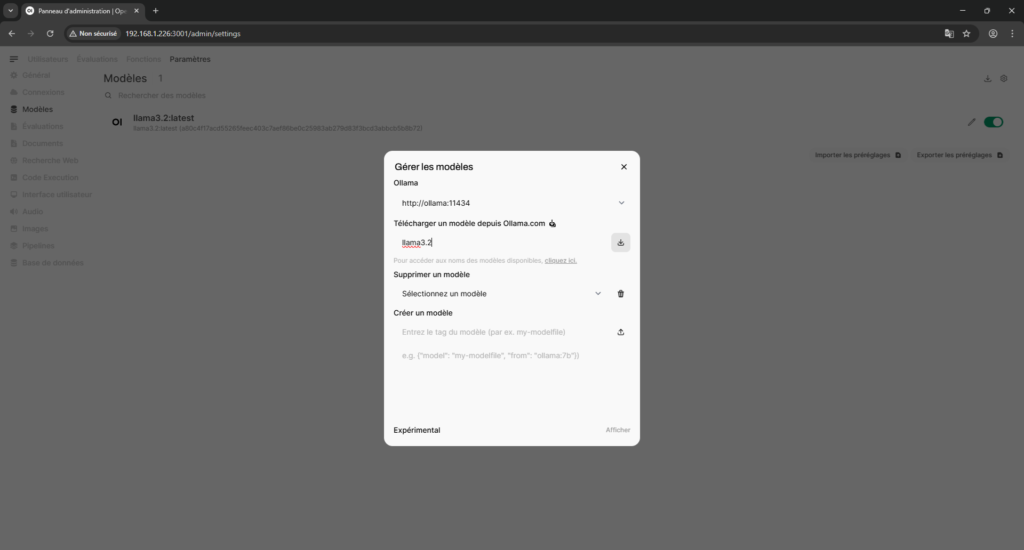

Une fois sur la page d’accueil de Votre intelligence artificielle sur Docker, rendez-vous dans votre compte en haut à droite, puis dans « Panneau d’administration/Paramètres » et enfin dans « Modèles ». Ensuite, cliquer sur l’icône de téléchargement, saisissez le nom du modèle « llama3.2 » et télécharger le.

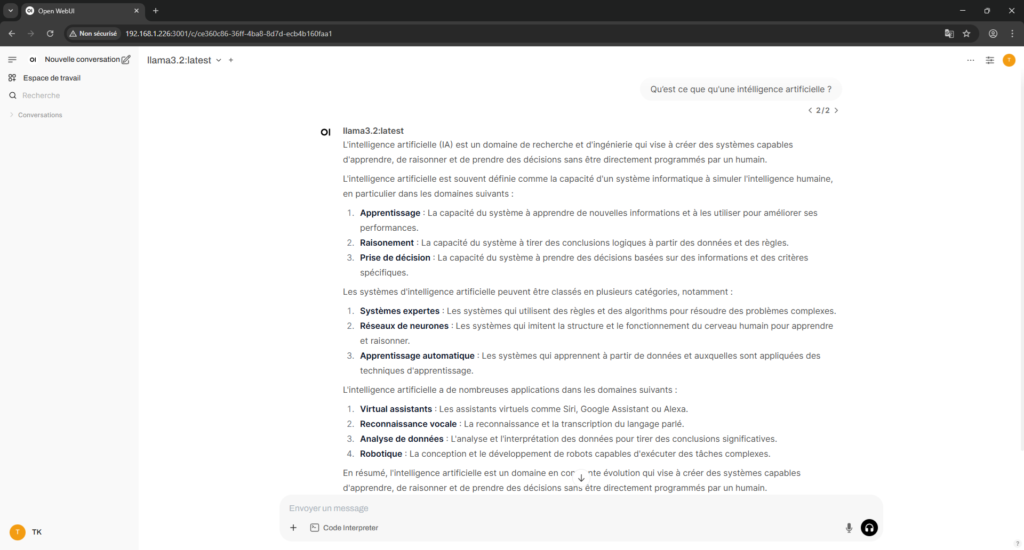

De retour sur l’accueil, vous pouvez maintenant lui poser votre première question !

En conclusion, Ollama vous permet de déployer une intelligence artificielle sur Docker très rapidement. L’utilisation de fichier llm en local est très gourmand en ressource mémoire, processeur ainsi qu’en disque dur (il est conseillé d’exploiter votre GPU si possible). Par contre, vous pourrez utiliser Ollama avec les API comme OpenAI ou Mistral AI par exemple.

-

Une intelligence artificielle local sur Docker -

Comment installer Nextcloud sur Docker -

Installer un serveur Minecraft sur Debian -

Comment déployer Emby sur Docker -

Comment installer Plex sur Docker -

Comment installer WordPress sur Debian

2 réponses à “Une intelligence artificielle local sur Docker”

Merci à vous pour cet article très instructif sur la mise en place d’une intelligence artificielle locale sur Docker. J’ai été particulièrement intéressé par la possibilité de créer et de personnaliser des modèles de langage en fonction de mes besoins. L’utilisation de fichiers llm en local est une excellente idée pour garantir la confidentialité et la sécurité des données. Je vais certainement essayer votre méthode.

Bonjour Jérome,

Merci à toi pour le commentaire ! C’est exactement pour la confidentialité que cela m’intéresse, j’aimerais le coupler à ma domotique.

Laisser un commentaire